泄漏的DeepSeek R2信息揭示其运用自主AI基础设施实现性能提升

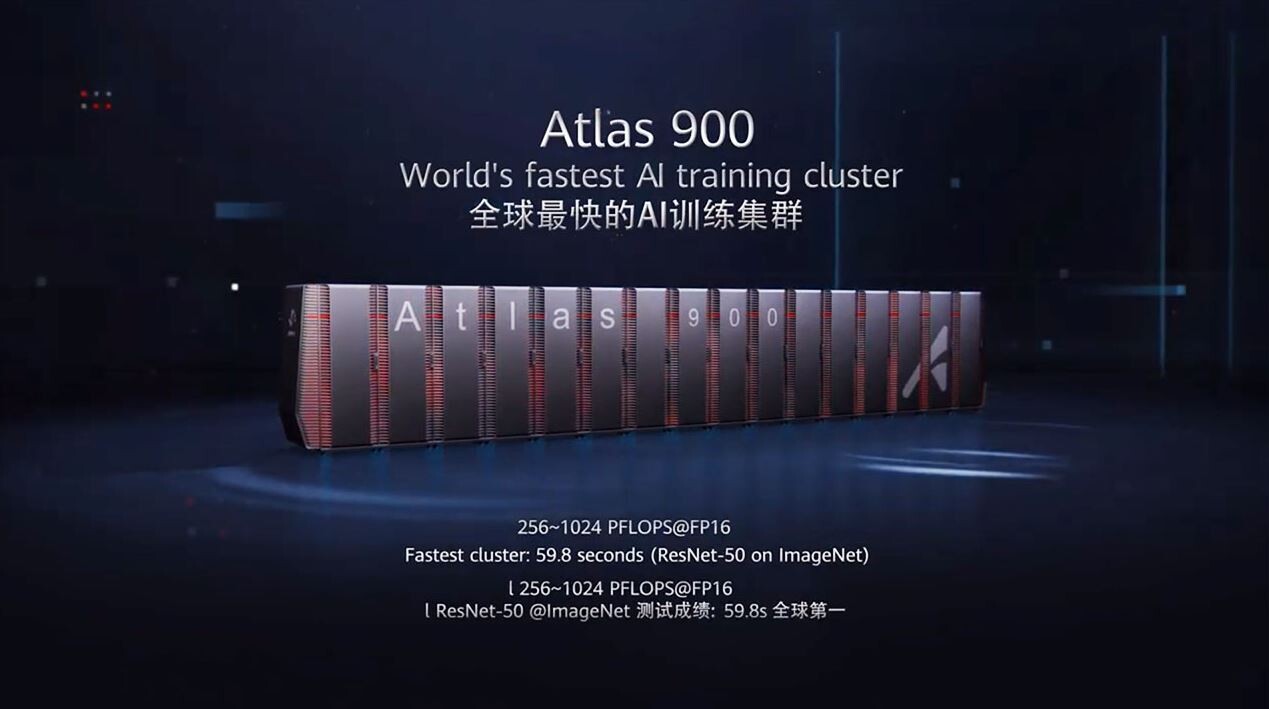

据知名 AI 业内人士@iruletheworldmo 在 X 上透露,DeepSeek 凭借其 R1 模型席卷 AI 世界之后,目前正在准备发布一款据称性能得到大幅改进的全新 DeepSeek R2 模型。在华为 Ascend 910B 芯片集群、潜在的华为 Atlas 900 以及 DeepSeek 内部分布式训练框架的支持下,R2 将这些加速器的利用率提升至令人印象深刻的 82%,相当于 512 PetaFLOPS 的 FP16 性能——计算能力为 exaFLOP 的一半。

根据华为实验室的数据,这大约是 NVIDIA 旧款 A100 集群所提供的性能的 91%,但 DeepSeek 声称它将单位训练成本降低了 97.3%。

DeepSeek R2 背后是一个精心培育的合作伙伴生态系统。拓维信息是昇腾系列的领先OEM厂商,承接了DeepSeek超过一半的超级计算硬件订单,而曙光则提供每台功率高达40kW的液冷服务器机架。为了控制功耗,旭创科技的硅光收发器与传统解决方案相比,可再降低35%的功耗。

从地理位置上看,运营分布在几个主要的枢纽:润建股份运营着华南超级计算中心,每年的合同金额超过50亿元人民币,中贝通信在西北地区保留了1500PetaFLOP的备用计算能力,以应对峰值需求。

在软件方面,DeepSeek R2已经支持私有部署和微调,通过云赛智联平台为15个省的智慧城市计划提供支持。由鸿博股份旗下英博数字负责监管的华北节点将计算能力再提升3000PetaFLOP。

如果计算能力不足,华为准备部署其CloudMatrix 384 系统,该系统定位为 NVIDIA 200 GB NVL72 的国产替代方案。它配备 384 个 Ascend 910C 加速器,可实现 NVL72 集群整体 petaFLOPS 的 1.7 倍和 HBM 总容量的 3.6 倍——然而,其单芯片性能明显落后,功耗几乎是 NVL72 集群的四倍。

踩一下[0]

站长云网

站长云网

顶一下[0]